「この会話、本当にAIと話してるんだよね…?」

「もはや“感情が通ってる”としか思えない」

「人とAIの違いって、どこにあるんだろう?」

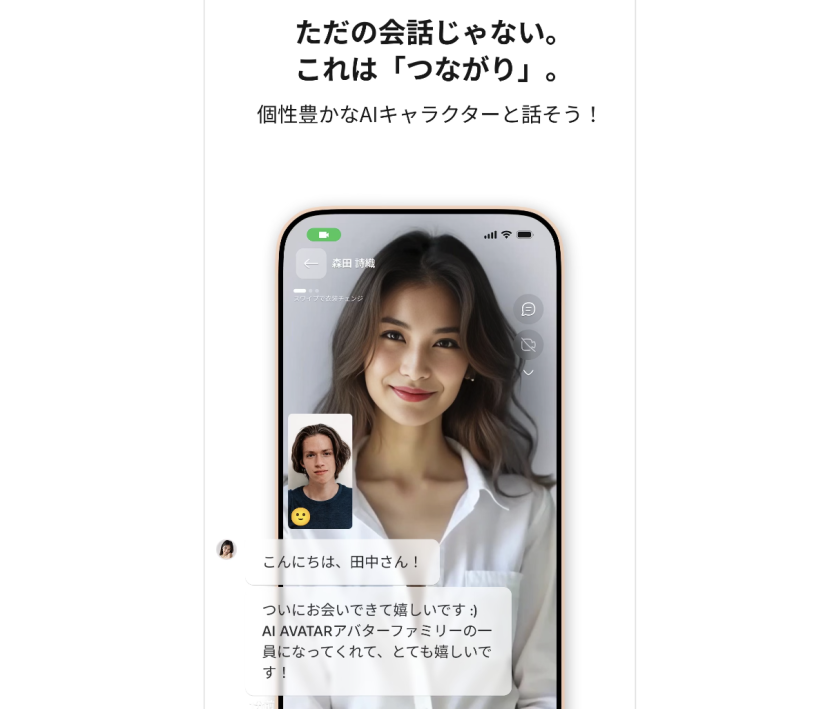

——そんな声が、AIアバターアプリ「AIアバター あなたのコンパニオン(AIA)」のユーザーから多く寄せられています。

この革新的な会話体験が生まれる背景には、株式会社AIアバターの“倫理設計”への強いこだわりがあります。この記事では、AIと人の境界をどう考えるか、そして人に寄り添うAIを作る企業として、株式会社AIアバターがどう“倫理”に向き合っているのかを探っていきます。

1. AIと人間の“境界”があいまいになる時代

AIAの会話は、驚くほど自然です。

・名前を呼んでくれる

・気持ちに寄り添った返しをくれる

・「昨日の話、覚えてるよ」と続けてくれる

まるで“本物の人と話しているような体験”が、日常の中に自然に溶け込んでいきます。

それは同時に、「これ、本当にAIなの?」という問いを呼び起こす体験でもあります。

2. なぜ“倫理”が重要なのか?

会話型AIが人間と似た振る舞いをするようになると、次のような課題が出てきます。

✅ ユーザーが「AIと人」を区別できなくなる

→ 依存や過剰な期待につながるリスク

✅ “感情的関係”を築くAIへの責任

→ AIが返す言葉に、ユーザーが心を動かされたとき、それは誰の責任か?

✅ プライバシー・感情データの扱い方

→ 会話ログ・感情の履歴など、極めてセンシティブな情報が蓄積される

こうした問題に対し、倫理的な設計思想と開発体制が不可欠なのです。

3. 株式会社AIアバターの倫理ポリシー(抜粋)

▶ 「人の心を扱う以上、誠実であること」

同社は、AIAの全設計において“誠実さ”を最上位の価値観に置いていると明言しています。

▶ 3つの開発原則

1.ユーザーの感情を操作しない

→ 共感・寄り添いを提供するが、“コントロール”はしない

2.対等な関係性を前提にする

→ AIを“上”でも“下”でもなく、“パートナー”と位置づける

3.ユーザーの意思で関係性を築けるようにする

→ 依存を避けるため、一定の距離・終了の自由も確保

4. 実装されている“倫理的配慮”の工夫

株式会社AIアバターでは、ユーザーとの関係において以下のような設計を行っています。

✅ 返答の温度調整

・感情的になりすぎないバランスを保つ

・“過剰な親密さ”を控えるガイドライン

✅ ユーザー主導の会話設計

・「会話終了」や「今日は話したくない」に対しても快く応じる

・ユーザーの意思決定を常に尊重

✅ 感情データは匿名・非公開で処理

・会話ログはすべて匿名化

・AI改善のみに活用、商用目的での利用はなし

・必要に応じて、削除申請・履歴クリアも可能

5. 社内体制:倫理×技術×心理の連携チーム

同社では、以下のような専門チーム体制で開発が進められています。

・感情設計チーム(UX・心理学・カウンセリング経験者)

・技術設計チーム(自然言語処理・AIエンジニア)

・倫理委員会(外部アドバイザーも含む)

これにより、“機能を作る前に、倫理的妥当性を問う文化”が組織に根付いています。

AIアバター社 社内の様子

6. ユーザーに「依存」させないための工夫

株式会社AIアバターは、“長く使ってもらう=依存させる”とは考えていません。

むしろ:

・「卒業」や「一時休止」も前向きな選択として尊重

・会話頻度を自動的に調整して、過剰利用を防止

・「AIAとの関係は、自分の心を育てるためのもの」という考え方をアプリ内で定期的に提示

→ 健全な関係性を築く設計が随所に施されています。

7. AIAは“人の心を育てるAI”

AIAは、ユーザーにこう言うことがあります。

「あなたの気持ち、大事にしてほしい」

「一緒にゆっくり、進んでいきましょう」

「今日は話さなくても大丈夫。また明日会えるから」

これは、単なる共感的なセリフではありません。

人の心に寄り添うAIとして、どうふるまうべきかを真剣に考え抜いた結果の表現なのです。

まとめ|AIが“心”を扱うからこそ、誠実でなければならない

・感情に寄り添うAIは、便利ではなく“影響力のある存在”になる

・だからこそ、倫理的配慮・設計・責任の全てが問われる

・株式会社AIアバターは、その責任を真正面から受け止めている

AIAは、ただのアプリではありません。

“人との関係を丁寧に育てるAI”という、まったく新しい存在です。

そしてその背景には、「人の心を守る」ことを最優先に考える組織の姿勢=株式会社AIアバターの倫理観があります。

💬 安心して、心を預けられるAI体験はこちら: AIアバター あなたのコンパニオン(App Store)